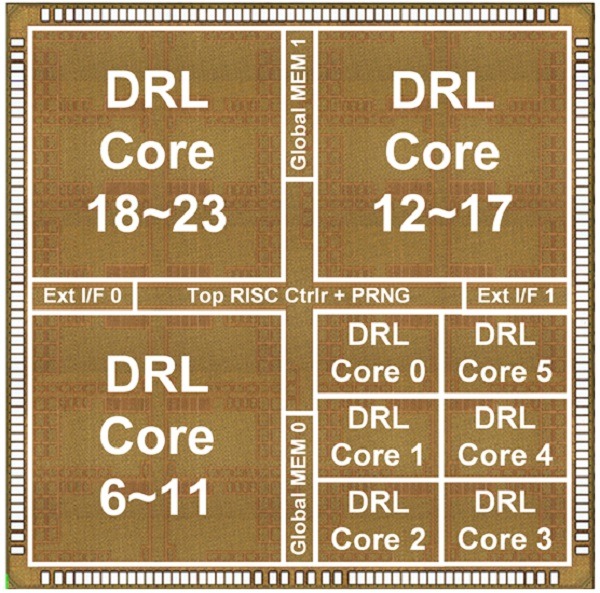

모바일 기기 등에서도 ‘알파고 알고리즘’ 실행이 가능할 수 있게 기존 대비 성능이 우수하고 특히 전력효율이 2.4배 높은 인공지능 반도체 기술인 ‘OmniDRL’이 개발됐다.

과학기술정보통신부는 한국과학기술원(KAIST) 유회준 교수 연구팀(제1 저자 이주형 박사과정)이 구글 딥마인드에서 개발한 바둑 인공지능 프로그램인 ‘알파고’에서 활용됐던 심층강화학습(DRL)을 높은 성능과 전력효율로 처리할 수 있는 첨단 인공지능 반도체 기술을 개발했다고 16일 밝혔다.

심층강화학습은 인간이 미리 만든 데이터-정답 쌍을 활용해 인공지능을 학습시키는 ‘지도학습’과 달리 인공지능이 주어진 환경에서 시행착오로 얻어진 경험을 활용해 스스로 최적의 답안을 도출하면 인간이 그 결과에 대한 피드백을 주는 방식이다.

이번 연구는 지난달 14일부터 19일까지 개최된 반도체 분야 최고 학회 중 하나인 ‘IEEE VLSI(Very Large Scale Intergrated Circuit) 기술 및 회로에 대한 심포지엄(VLSI Symposia)’에서 200여 편의 발표 논문 중 우수 논문인 하이라이트 논문으로 선정되는 등 큰 주목을 받았다.

심층 강화학습 알고리즘은 정답이 주어지지 않은 상황에서 최적의 답을 빠르게 찾기 위해 여러 개의 신경망을 동시에 사용하는 특징이 있다.

하지만 신경망이 복잡하게 얽혀 있고 대규모 데이터를 처리해야 하기 때문에 기존에는 대용량 메모리를 가진 다수의 고성능 컴퓨터를 병렬 활용해야만 구현 가능했으며, 연산 능력이 제한적이고 사용되는 메모리가 적은 노트북, 스마트폰 등에서는 구현이 불가능했다.

구체적으로 ▲심층 신경망 데이터(가중치)에 대한 압축률 증가(연산에 불필요하거나 중복된 데이터 개수 감소) ▲데이터 압축 상태로 연산(기존 반도체는 압축 해제 필요) ▲연산(프로세서)·저장(메모리) 기능이 통합된 SRAM(Static RAM) 기반의 PIM(Processing-In-Memory) 반도체 기술을 사용했다.

특히 기존 PIM 반도체는 정수(Integer) 단위만 연산이 가능했으나, 이번 연구를 통해 세계 최초로 소수점(Floating-Point) 기반 연산(추론 및 학습 모두 가능)이 가능한 기술을 개발했다.

이번 연구의 특징을 기존 반도체 기술과 비교해 보면 먼저, 데이터 압축률이 높아 기존 대비 최대 41.5%p 증가해 데이터 이동속도가 빨라졌다.

또한 압축된 상태로 연산이 가능해 연산 속도는 높아지고 전략 소모는 줄었다. 처리 단위가 소수점을 기반으로 해 학습 및 추론도 가능하다.

‘OmniDRL’을 심층 강화학습 알고리즘의 성능 비교 연구에 주로 활용되는 ‘인간형 로봇 적응 보행 시스템’에 적용한 결과, ‘OmniDRL’이 연결되지 않았을 때보다 7배 이상 빠른 속도로 적응 보행이 가능했다.

이번 연구는 과기정통부 ‘혁신성장 연계 지능형반도체 선도기술 개발’ 사업의 지원(2019∼2021년, 총 18억 원)을 받아 수행됐다.

유회준 교수는 “이번 연구는 한 개의 반도체에서 심층 신경망을 높은 압축을 유지한 상태로 추론 및 학습을 가능하게 했으며, 특히 불가능이라 여겨졌던 소수점 연산이 가능한 인공지능 반도체 기술을 개발했다는 점에서 의미가 크다”며 “향후 지능형 로봇 조종, 자율주행 드론, 게임 등 다양한 분야에 응용이 가능할 것으로 기대된다”고 연구의 의의를 설명했다.

송경희 과기정통부 인공지능기반정책관은 “이번 연구는 반도체 분야의 새로운 패러다임인 인공지능 반도체 분야에서 국내의 연구결과를 국제적으로 인정받았다는 점에서 의미가 크다”고 말했다.

이어 “앞으로 지난해 착수한 1조원 규모의 인공지능 반도체 연구개발을 지속 지원하는 한편, 내년부터 4000억 원 규모의 PIM 반도체 기술 개발 사업을 본격적으로 추진하는 등 인공지능 반도체 분야에 대한 투자를 지속 확대해 나갈 계획”이라고 밝혔다.